STM32H750 內部記憶體不到 1MB,在記憶空間使用大的情況下,我們需要在晶片外部增加外部 SRAM 以滿足空間需求。如何宣告一個變數映射到這外部記憶體?對於編譯器版本 AC5 或 AC6 最安全的做法是底下這樣宣告:

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(9)

問題:STM32晶片用 ARM compiler 6 版本編譯,不勾選 MicroLIB,如下圖設定。燒錄後,晶片不會自動運行?

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(6)

最近 DeepSeek 模型為何讓人驚艷,打破了 AI 訓練必須不斷累積算力的迷思。先說說大學時代的理工學院,曾經修過數位訊號處理(DSP),可以了解到數位訊號的數學運算通常以浮點數(floating point)形式進行運算,因此當時DSP晶片有浮點運算(floating point)與定點運算(fixed point)之分。然而,浮點運算的硬體成本較高,且浮點DSP晶片價格昂貴。面臨的問題是若要提升產品的市場競爭力,往往需要採用成本較低的定點運算。由於定點運算在數值範圍和精度上有所限制,因此必須對數學運算架構進行大幅調整,並對演算法加以優化。例如,在浮點DSP上,計算三角函數(如 sin 函數)通常具有較高效能,而在定點運算環境下,為了提高效率,可以使用三角函數的查表法(Look-up Table, LUT),即以記憶體空間換取運算時間,從而降低運算成本。此外,在某些資源受限的嵌入式系統中,演算法的設計和優化需要投入更多心力,以在有限的算力和記憶體條件下達到最佳效能。

訓練 AI 組成的要素:算力, 數據, 模型演算法。算力建立在硬體資源,模型算法則是數學計算和軟體工程。同理,DeepSeek 在有限的算力資源環境下,若要提高計算效能,往往需要透過優化模型架構、調整演算法的計算方式,以降低運算複雜度,進而節省算力,儘管這可能會以部分精準度為代價。此外,優化資料結構的儲存與排列方式也是一種有效的策略,能夠提升存取效率,減少計算負擔,從而進一步優化整體效能。最後,DeepSeek v3 在數理, 自然, 程式碼...領域方面表現的結果與 OpenAI 不相上下。

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(9)

Edge Impulse 是一個提供 AI 模型訓練的雲端平台 https://edgeimpulse.com/,也提供幾個免費的模型讓新註冊者使用,適合初學者入門學習 AI 模型訓練(Train),乃至生成推理參數(Inference)。此外,該平台提供的模型適用於邊緣運算,訓練後的模型參數可以移植到資源有限的嵌入式系統上面進行 AI 的推理,犧牲部分模型的精準度來換取更多周邊設備的推理應用。在網站,Edge Impulse 列出一些合作的硬體設備廠商或可移植的模組,我們可以根據這方向找適合的模組來實現。

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(18)

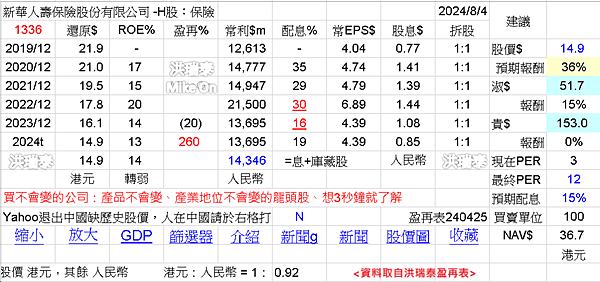

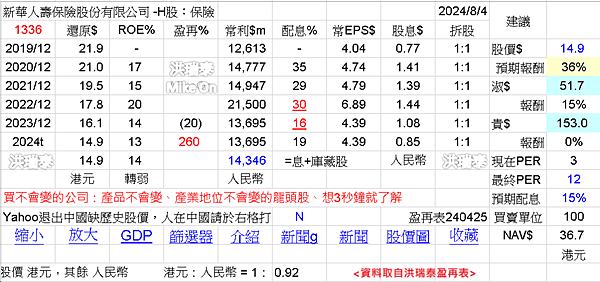

資料取自洪瑞泰盈再表

整理港股中的保險H股:新華保險,中國平安,中國太保。

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(3)

![[筆記] RTSP stream server on Win [筆記] RTSP stream server on Win](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEikmR85bzHI48SzwmNTpmYW70w-XXWf00YF8pbEi2R-WdrMfT2CRncqQtx3HHDqJ6ZXKtktNG7aJ9ztmCY7X7-AkLcRzcG6eHqRW8HuYkOEqWBeZgf35PBeaci04trY1Nt-z1K2upGtszLlXtLLtx4aeOe4fpmgewC10w-03e-ca1poiynkHnXISSPF/s16000/%E8%9E%A2%E5%B9%95%E6%93%B7%E5%8F%96%E7%95%AB%E9%9D%A2%202024-07-26%20142130.png)

➤ 準備套件

MediaMTX:到 github 網站下載 zip 包 https://github.com/bluenviron/mediamtx,參考 [1]

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(1,843)

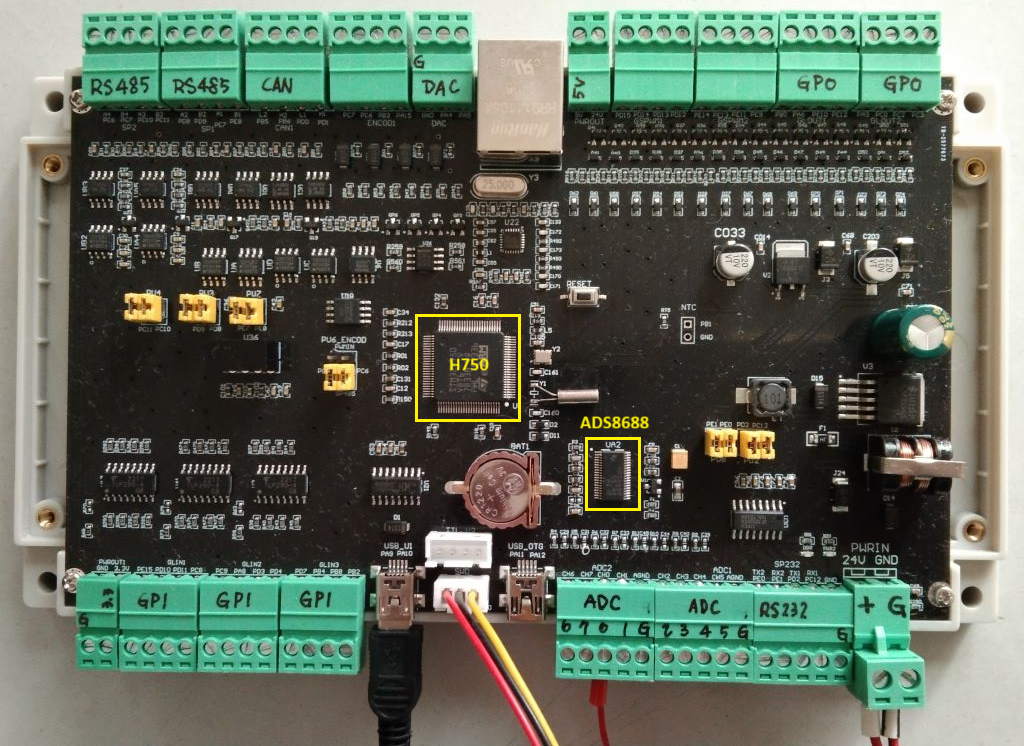

在實務上,經常使用意法半導體的 MCU,本文介紹一塊高效能的工控板,如圖一所示,以 STM32H750 為基礎,其核心為 ARM Cortex-M7,最高運算時脈 480MHz。底下列出這塊工控板的周邊介面:

1) 12 路光耦合GPI

2) 8 路光耦合GPO (有帶+24V電源的接點)

4) 2 路DAC (12-bit, 0~10V)

5) 8 路ADC (16-bit, -10.24V~+10.24V, 外接

ADS8688晶片)

6) RS-485 x 4, RS-232 x 1, FDCAN-bus x 2, USB-to-COM x 1

7) Ethernet RJ-45 (外接

LAN8720 PHY)

8) 8 路高速 PWM 輸出

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(5)

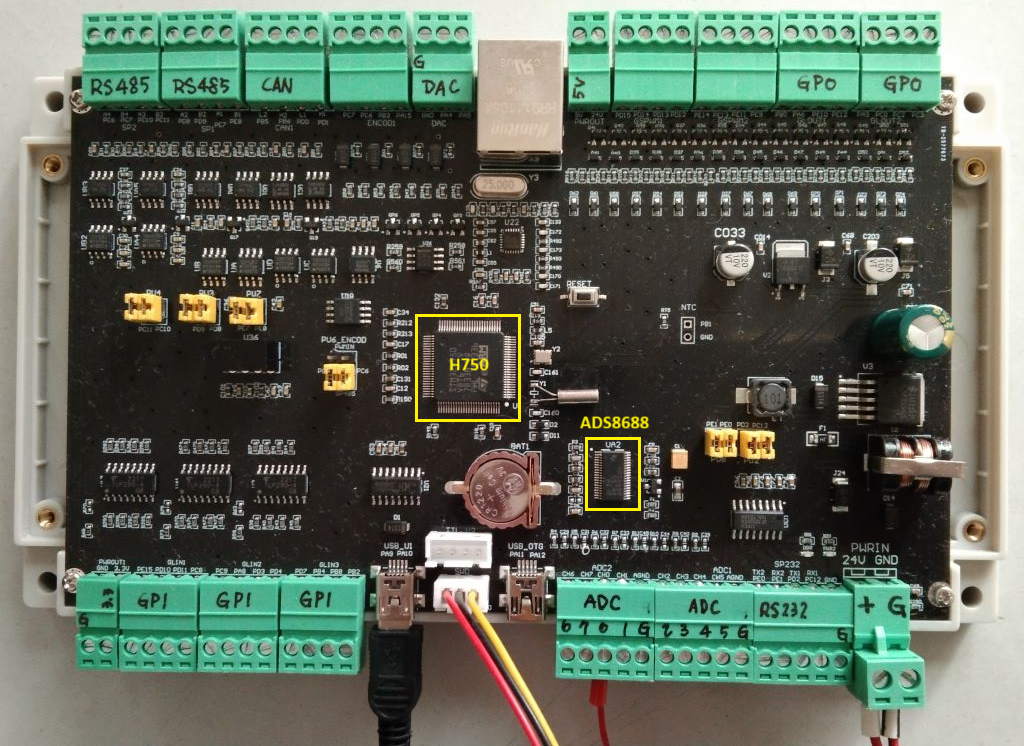

意法 STM32 系列晶片在工業或控制領域使用是非常廣泛的,這裡介紹一塊 F407 的控制板,板子將晶片的周邊電路已經拉出來,並接到歐式端子頭,如圖一所示。簡單介紹 STM32F407 核心是 ARM Cortex-M4F,晶片最高工作頻率 168MHz,底下列出這塊控制板的周邊介面:

1) 16 路光耦合隔離 GPI

2) 16 路光耦合隔離 GPO (有帶+24V電源的接點)

3) 4 路光耦合隔離 GPO (無電源的接點)

4) 2 路 DAC (12-bit, 0-10V)

5) 8 路 ADC (24-bit, 0~10V, 7500 samples/sec) : 接

ADS1256 晶片

6) RS-485(兩組), RS-232(一組), CAN-bus(兩組)

7) Ethernet RJ-45 接口:接

LAN8720 PHY 晶片

8) 8 路高速 PWM 輸出

9) 2 路高速 PWM 輸入

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(14)

![[模組] STM32 藍芽模組 -- BlueNRG-2 模 [模組] STM32 藍芽模組 -- BlueNRG-2 模](https://blogger.googleusercontent.com/img/a/AVvXsEi08J8_rDHxU0MauLN6ikg0Iq2Z0Bd4gUyur-RjcI3MRHiALLf5mAqux7nmHLBPM6nOjBf_CmYs-wwDEraZA9wh76biNcdV9RSL8Tbb4nGlI-f_HdYMGkUgi_jbj_IZ1lOwGr3lIFM_hK0QOCakKcS3N9MZBpj2Rgr871-SNFXvcIWZFHija7iBmlfo=w640-h228) 模組介紹BlueNRG

模組介紹BlueNRG系統有兩款已認證的藍芽模組,一款型號為

BLUENRG-M2SA(對應的開發板名稱:

STEVAL-IDB008V1M),一款為

BLUENRG-M2SP。模組的核心是

STM32 Cortex-M0,它本身就是一顆

MCU,再外接常見的通訊界面,如:

UART、

SPI、

I2C…等。官方網站提供該模組的

SDK程式碼,到官方網站下載

BlueNRG-1_2 DK-3.2.3.0-Setup.exe,執行安裝後,如下圖所示。

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(13)

過去常常思考一個問題,股市的量價關係如何與物理力學產生連結呢?股市的技術指標如何與牛頓定律扯上關係呢?我在這裡不探討數學式子,單純從概念來思考。以下謹代表個人研究心得,不負責盈虧。首先,股市的成交量能代表推力或衰退力道,股價代表移動的距離大小,股本可視為一個物體的質量。在股海時間久了,普遍的認知就是股本越大越需要更大的成交量能來推動價格,小股本的公司只需一點推力就能產生推升的效果,這樣的邏輯可以套用到力學當中的牛頓第二定律 F = MA。

漢亞科技 Han-Ya 發表在 痞客邦 留言(0) 人氣(10)

![[筆記] RTSP stream server on Win [筆記] RTSP stream server on Win](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEikmR85bzHI48SzwmNTpmYW70w-XXWf00YF8pbEi2R-WdrMfT2CRncqQtx3HHDqJ6ZXKtktNG7aJ9ztmCY7X7-AkLcRzcG6eHqRW8HuYkOEqWBeZgf35PBeaci04trY1Nt-z1K2upGtszLlXtLLtx4aeOe4fpmgewC10w-03e-ca1poiynkHnXISSPF/s16000/%E8%9E%A2%E5%B9%95%E6%93%B7%E5%8F%96%E7%95%AB%E9%9D%A2%202024-07-26%20142130.png)

![[模組] STM32 藍芽模組 -- BlueNRG-2 模 [模組] STM32 藍芽模組 -- BlueNRG-2 模](https://blogger.googleusercontent.com/img/a/AVvXsEi08J8_rDHxU0MauLN6ikg0Iq2Z0Bd4gUyur-RjcI3MRHiALLf5mAqux7nmHLBPM6nOjBf_CmYs-wwDEraZA9wh76biNcdV9RSL8Tbb4nGlI-f_HdYMGkUgi_jbj_IZ1lOwGr3lIFM_hK0QOCakKcS3N9MZBpj2Rgr871-SNFXvcIWZFHija7iBmlfo=w640-h228)